Ataques com deepfakes podem enganar ‘facilmente’ reconhecimento facial em tempo real

"Testamos 10 soluções e descobrimos que nove delas eram extremamente vulneráveis a ataques de deepfakes", diz chefe de startup responsável por testesBy - Liliane Nakagawa, 29 maio 2022 às 22:13

Uma série de testes revelou que nove em cada 10 fabricantes de software líderes de reconhecimento facial em tempo real falharam contra ataques deepfake, de acordo com o relatório da Sensity AI, uma startup focada em segurança de identidade.

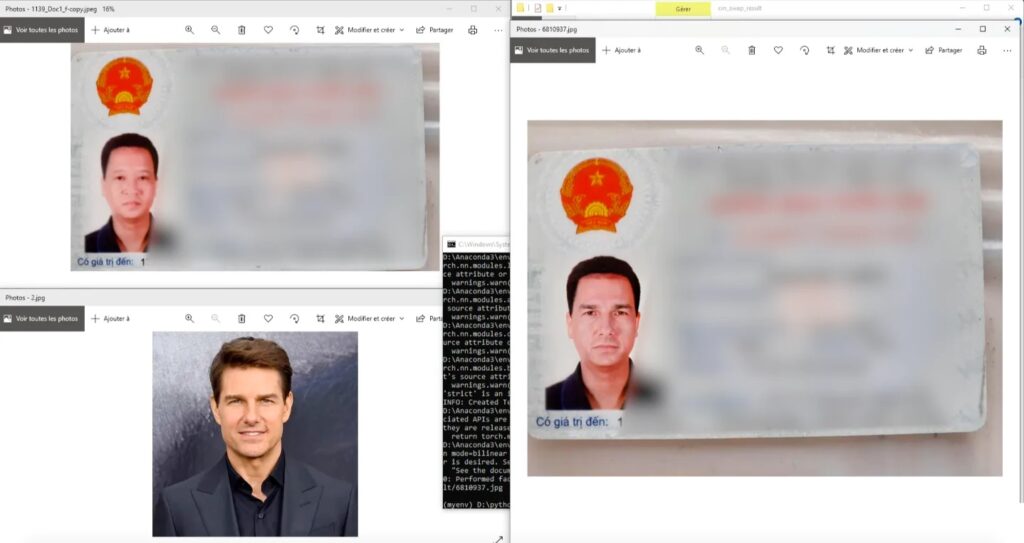

Nos testes, os engenheiros responsáveis escanearam a imagem de uma pessoa a partir do documento de identidade e mapearam a semelhança do rosto com os de outra pessoa. Os ataques contra o software submeteram à imagem a “testes de vivacidade” (Liveness Detection), as quais tentam autenticar as identidades em tempo real, confiando em imagens ou fluxos de vídeo de câmeras como o reconhecimento facial usado para desbloquear telefones celulares, por exemplo.

Troca de identidade visual realizada na foto de identificação. Ter uma foto do alvo é suficiente para usá-lo como rosto. Imagem: Reprodução/Sensity AI

De acordo com a Sensity, nove das 10 empresas testadas falharam; os nomes das fabricantes suscetíveis aos ataques de deepfakes ao vivo não foram publicados por razões legais. “Dissemos a eles ‘parece que você é vulnerável a este tipo de ataque’ e eles disseram ‘não nos importamos'”, disse Francesco Cavalli, chefe de operações da Sensity, ao The Verge. “Decidimos publicá-lo porque pensamos que, em nível corporativo e em geral, o público deveria estar atento a estas ameaças”.

“Testamos 10 soluções e descobrimos que nove delas eram extremamente vulneráveis a ataques de deepfakes”, disse o chefe de operações da Sensity, Francesco Cavalli.

Para bancos e para autoridades governamentais, os testes de vivacidade são arriscados, especialmente se essas instituições usam a autenticação biométrica automatizada. Embora nem sempre os ataques sejam fáceis de serem realizados, “às vezes tudo o que eles [atacantes] precisam são telefones especiais baratos disponíveis no mercado por algumas centenas de dólares, capazes de sequestrar a câmera móvel e injetar modelos deepfake pré-fabricados, como aconteceu em um esquema gigantesco contra o sistema tributário chinês em 2021”.

“Eu posso criar uma conta; posso mover dinheiro ilegal para contas bancárias digitais de carteiras criptografadas”, diz Cavalli. “Ou talvez eu possa pedir uma hipoteca porque hoje as empresas de empréstimo online estão competindo entre si para emitir empréstimos o mais rápido possível”, exemplificou Cavalli.

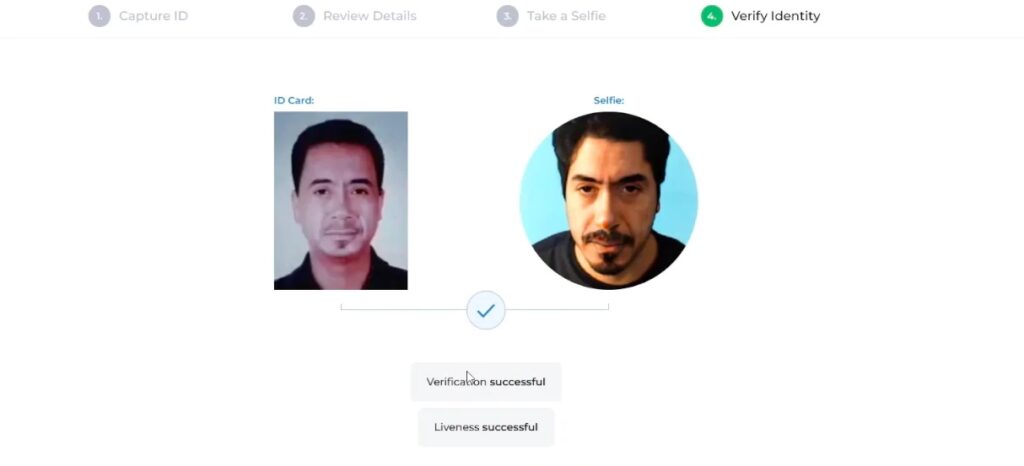

O relatório ainda alerta que a maioria das empresas que confiam no método KYC — Know Your Costumer (processo de identificação e verificação da identidade do cliente), desconhece que, apesar dos esforços de se evitar fraudes online aplicando tecnologias avançadas, a verificação de identidade não bem projetada, como o Face Matching (correspondência facial) e o Liveness (tanto ativo quanto passivo), ainda não podem fornecer segurança suficiente. Como prova o teste, deepfakes podem facilmente falsificar os sistemas KYC à medida que a tecnologia evolui.

Face Matching (correspondência facial) e o Liveness podem ser facilmente enganadas por deepfakes. Imagem: Reprodução/Sensity AI

Deepfake: os riscos que acompanham a inteligência artificial

Os vídeos gerados por inteligência artificial, nos quais substituem o rosto de uma pessoa em um vídeo existente por uma outra semelhante, conhecidos como deepfakes, têm aumentado 330% de outubro de 2019 a junho de 2020, segundo a startup Deeptrace.

O resultado da série de testes da Sensity AI não é inédito de forma a representar um perigo para sistemas de reconhecimento facial. A falsificação de identidade não só ameaça sistemas de segurança, mas pode influenciar a opinião pública durante uma eleição ou implicar uma pessoa em um crime.

“Imagine o que você pode fazer com contas falsas criadas com estas técnicas”. E ninguém é capaz de detectá-las”, advertiu Cavalli.

Com informações de The Verge e The Register e VentureBeat

Comentários