Está cada vez mais difícil explicar como IA funciona, alertam pesquisadores

À medida que esses sistemas se tornam mais complexos, os humanos se tornam menos capazes de compreendê-los, o que entre outros problemas, dificulta a prestação de contasBy - Liliane Nakagawa, 5 novembro 2022 às 16:30

Há muitos problemas que circundam o universo da inteligência artificial (IA). Entre os milhares deles, e o que preocupam estudiosos quanto ao desenvolvimento da tecnologia, é explicar como ela funciona e determinar a razão por trás dos resultados que tem.

Esse problema é semelhante à inexplicabilidade humana, em situações em que raramente questionamos decisões básicas do nosso cotidiano e, caso fizéssemos, não poderíamos identificar as razões exatas de nossas preferências, emoções e desejos em um dado momento.

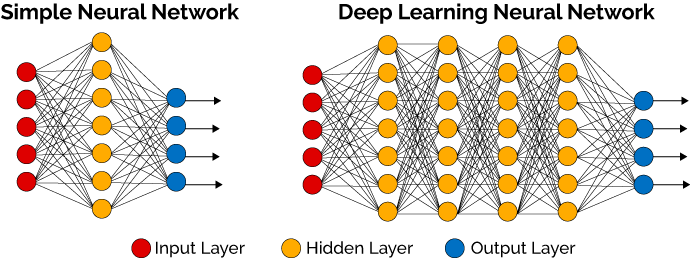

As redes neurais profundas (DNN), construídas por inúmeras camadas de processamento treinadas por dados produzidos por humanos e com objetivo de imitar as redes neurais de nossos cérebros, muitas vezes parecem herdar, além da inteligência humana, essa inexplicabilidade que nos esbarramos em situações básicas do dia a dia.

Rede Neural Simples e Rede Neural Profunda (Deep Learning). Imagem: reprodução/DeepLearningBook

A maioria dos sistemas de inteligência artificial são modelos de caixa preta, ou seja, são vistos apenas em termos de entradas e saídas. No entanto, os cientistas não tentam decifrar o que há no interior dessa caixa, ou os processos opacos que o sistema empreende, desde que obtenham a saída que estão procurando.

Então, qual seria o problema? A começar pelos dados pelos quais esses tipos de sistemas inteligentes são treinados; muitas vezes, eles são inerentemente tendenciosos, imitando preconceitos raciais e de gênero existentes em nossa sociedade. Um exemplo dessa situação foi com o uso da tecnologia de reconhecimento facial, que já foi banida em diversas partes do mundo por apresentar equívocos, levando à prisão de pessoas inocentes, que geralmente são desproporcionalmente mal identificadas.

Uma resposta seria corrigir o sistema para que não haja falhas, entretanto, isso se torna difícil, em parte porque os desenvolvedores muitas vezes não conseguem explicar completamente como funcionam, o que dificulta a prestação de contas. À medida que esses sistemas se tornam mais complexos, os humanos se tornam menos capazes de compreendê-los.

Imagem: Ociacia/Shutterstok.com

Por isso, especialistas e pesquisadores em IA estão alertando desenvolvedores a darem um passo atrás e se concentrarem em como e por que um sistema produz certos resultados, em vez da possibilidade desses sistemas produzi-los com precisão e rapidez.

IA: precisão versus explicabilidade

“Se tudo o que temos é uma ‘caixa preta’, é impossível entender as causas das falhas e melhorar a segurança do sistema”, escreveu Roman V. Yampolskiy, professor de ciência da computação na Universidade de Louisville, em seu paper intitulado “Unexplainability and Incomprehensibility of Artificial Intelligence” (“Inexplicabilidade e Incompreensibilidade da Inteligência Artificial”, em tradução livre). “Além disso, se nos acostumarmos a aceitar as respostas da IA sem uma explicação, tratando-o essencialmente como um sistema Oracle, não seremos capazes de dizer se ele começa a fornecer respostas erradas ou manipuladoras”.

Tais modelos podem ser extremamente poderosos, com vasto número de cientistas e empresas sacrificando a explicabilidade em função da precisão. Eles têm sido usados largamente para carros autônomos, chatbots de atendimento ao cliente, diagnósticos de doenças, além de outras tarefas executadas, às vezes, se saindo melhores que o desempenho humano. Como por exemplo, máquinas que ‘lembram’ de um trilhão de informações, cuja taxa de processamento e computação são muito mais rápidas e melhores que a de humanos.

Entre os inúmeros modelos de aprendizagem profunda, ou deep learning, incluem-se as redes adversas generativas (GANs), frequentemente usadas no treinamento de modelos gerativos de IA, como o gerador de texto para imagem MidJourney AI. Essencialmente, as GANs colocam os modelos de inteligência artificial uns contra os outros em tarefas específicas; aquele que demonstrar melhor desempenho, é colocado contra outro modelo, permitindo que o modelo se itere e se aperfeiçoe na tarefa.

Entretanto, os desenvolvedores não conseguem explicar a criação desses modelos. “Eu acho que em muitos casos, as pessoas olham para estes modelos de caixa preta como uma resposta à falta de recursos. Seria muito conveniente ter um sistema automatizado que pudesse produzir os tipos de resultados que eles procuram a partir do tipo de insumos que têm”, disse Emily M. Bender, professora de linguística da Universidade de Washington, à Motherboard.

“Se você tiver um conjunto de dados composto de tais entradas e saídas, é sempre possível treinar um sistema de caixa preta que pode produzir saídas do tipo certo — mas muitas vezes muito, muito mais difícil de avaliar se elas estão corretas”. Além disso, há muitos casos em que é impossível fazer um sistema onde as saídas estariam corretas de forma confiável, porque as entradas simplesmente não contêm informações suficientes”.

Imagem: divulgação/Tesla

Quando depositamos confiança em um sistema simplesmente por que ele fornece as respostas que se encaixam no que procuramos, não fazemos perguntas-chave: essas respostas são confiáveis, ou elas apenas nos dizem o que queremos ouvir? A quem os resultados acabam se beneficiando? E quem é responsável se isso causar danos?

“Se os líderes empresariais e os cientistas de dados não entenderem por que e como a IA calcula os resultados, isso cria um risco potencial para o negócio. A falta de explicabilidade limita o valor potencial da IA, inibindo o desenvolvimento e a confiança nas ferramentas de IA que as empresas implantam”, disse Beena Ammanath, diretora executiva do Deloitte AI Institute, à Motherboard.

“Os riscos são que o sistema possa estar tomando decisões usando valores com os quais discordamos, como decisões tendenciosas (por exemplo, racistas ou sexistas)”. Outro risco é que o sistema possa estar tomando uma decisão muito ruim, mas não podemos intervir porque não entendemos seu raciocínio”, disse Jeff Clune, professor associado de Ciência da Computação na Universidade de British Columbia.

Os sistemas de IA já estão constantemente reproduzindo viés na produção sem que desenvolvedores compreendam como. Ao interpretá-los de forma concreta, sem entender os potenciais vieses do sistema, cria-se consequências sociais segregacionistas. Um desses exemplos foi descoberto em um estudo pioneiro de 2018 intitulado ‘Gender Shades’, nele os pesquisadores Joy Buolamwini e Timnit Gebru descobriram que os sistemas de reconhecimento facial populares detectaram com mais precisão os homens com pele mais clara e tiveram os maiores erros ao detectar as mulheres com pele mais escura.

Os sistemas de reconhecimento facial, que são inclinados contra pessoas de cor e têm sido usados para tudo, desde habitação até policiamento, aprofundam os preconceitos raciais pré-existentes, determinando quem tem mais probabilidade de conseguir uma casa ou ser identificado como um criminoso, por exemplo. Sistemas preditivos de IA também podem adivinhar a raça de uma pessoa com base em raios X e tomografias computadorizadas, mas os cientistas não têm ideia do porquê ou como isso acontece. É menos provável que pacientes negros e mulheres recebam um diagnóstico preciso de sistemas automatizados que analisam imagens médicas, e não temos certeza do porquê.

Ao mesmo tempo, alguns especialistas argumentam que a simples mudança para modelos de IA abertos e interpretáveis — ao mesmo tempo em que permitem maior visibilidade desses processos – resultaria em sistemas que são menos eficazes.

“Há muitas tarefas neste momento em que as abordagens da caixa preta são de longe melhores do que os modelos interpretáveis”, disse Clune. “A lacuna pode ser suficientemente grande para que os modelos de caixa preta sejam a única opção, assumindo que uma aplicação não é viável a menos que as capacidades do modelo sejam boas o suficiente”. Mesmo nos casos em que os modelos interpretáveis são mais competitivos, geralmente há um tradeoff entre capacidade e interpretabilidade. As pessoas estão trabalhando para fechar essa lacuna, mas suspeito que ela permanecerá por um futuro previsível, e potencialmente sempre existirá”.

Imagem: Ociacia/Shutterstok.com

Embora já exista um subconjunto de IA conhecido como IA Explicável (XAI), as técnicas gerais que ela promove são frequentemente diminuídas e imprecisas ao englobar a verdadeira amplitude dos processos, e os desenvolvedores de IA não são incentivados a seguir este modelo.

A questão da explicabilidade tem a ver com o fato de que, como os sistemas de IA se tornaram tão complexos, as explicações gerais apenas aumentam o diferencial de potência entre os sistemas de IA e seus criadores, e os desenvolvedores de IA e seus usuários. Em outras palavras, a busca de explicabilidade adicional depois que um sistema de IA já está em funcionamento torna mais difícil a abordagem do que se você começar com ele.

“Talvez a resposta seja abandonar a ilusão de explicação e, em vez disso, concentrar-se em testar mais rigorosamente a confiabilidade, os preconceitos e o desempenho dos modelos, como tentamos fazer com os humanos”, disse Clune.

Nos últimos anos, houve um pequeno mas real empurrão por parte de alguns no setor para desenvolver “modelos de caixa branca”, que são mais transparentes e cujos resultados podem ser melhor explicados. Os modelos da caixa branca, no entanto, são um ramo relativamente novo da pesquisa de IA que está procurando tornar a IA mais explicável.

Os pesquisadores de IA dizem que dar aos usuários que são impactados por um determinado sistema um papel maior na participação no processo de desenvolvimento é um primeiro passo importante para tornar os sistemas de IA mais transparentes e que representem adequadamente as necessidades dos usuários.

“Muitas das explicações que as pessoas tratam como explicações realmente não são. Elas são redutoras, são escritas para os interesses dos desenvolvedores e o que os desenvolvedores acham importante explicar, ao invés do que o usuário precisa”, disse Os Keyes, candidato a Ph.D. no Departamento de Design e Engenharia Centrada no Ser Humano da Universidade de Washington, à Motherboard. “Sem dúvida, eu diria que há duas grandes mudanças na IA que seriam necessárias para mudar este estado de coisas, e a primeira é que, em última análise, isto é em parte um problema da enorme lacuna na prática entre os desenvolvedores e os usuários reais”.

“Uma participação mais ampla não apenas na construção do sistema, mas também perguntando, que perguntas são interessantes, que coisas precisam ser possíveis para que isto seja realmente explicável”, acrescentou Keyes. “Isso faria uma enorme diferença”.

Imagem: Ociacia/Shutterstok.com

Ammanath concorda que algumas das melhores práticas na promoção da explicabilidade incluem explicações sob medida e relatórios para as pessoas que se envolverão ou serão impactadas pelos sistemas automatizados. Na mesma linha, disse ela, os desenvolvedores precisam primeiro identificar as necessidades e prioridades das pessoas que serão mais afetadas.

Um problema mais desafiador é que muitos sistemas de IA são projetados para o conceito de universalismo — a ideia de que “[um] sistema é bom se funcionar em todos os lugares e em todos os momentos” Keyes explicou. “Mas o problema é que não é assim que a realidade funciona, pessoas diferentes vão precisar de explicações diferentes de coisas diferentes”. Se realmente queremos que a IA seja mais explicável, temos que realmente, fundamentalmente, mudar como imaginamos e como os desenvolvedores imaginam a inteligência artificial”.

Em outras palavras, se você construir uma IA explicável com um processo de projeto de tamanho único, “você acaba com algo onde tem explicações que só fazem sentido para um grupo de pessoas que estão envolvidas no sistema na prática”, disse Keyes. “A mudança interna é um conjunto [muito] mais amplo de envolvimento na decisão de explicar a quem, e o que significa explicável”.

O apelo de Keyes por sistemas de IA mais localizados e sua preocupação com a universalidade dos modelos de IA é o que os pesquisadores têm nos alertado nos últimos anos. Em um artigo de 2021 coautorizado por Bender e Gebru, que foi encerrado no Google por publicar esta pesquisa, os autores argumentam que o treinamento de modelos de IA com grandes dados torna difícil a auditoria para os enviesamentos embarcados. Eles escreveram que os grandes dados também não representam as populações que têm menos acesso à internet e “representam excessivamente os usuários mais jovens e os dos países desenvolvidos”.

Comentários