Nvidia e IBM trabalham em projeto para conectar GPUs diretamente a SSDs

Intitulada de Big Accelerator Memory, tecnologia vai tornar GPUs menos dependentes de processos envolvendo CPUsBy - Igor Shimabukuro, 16 março 2022 às 18:05

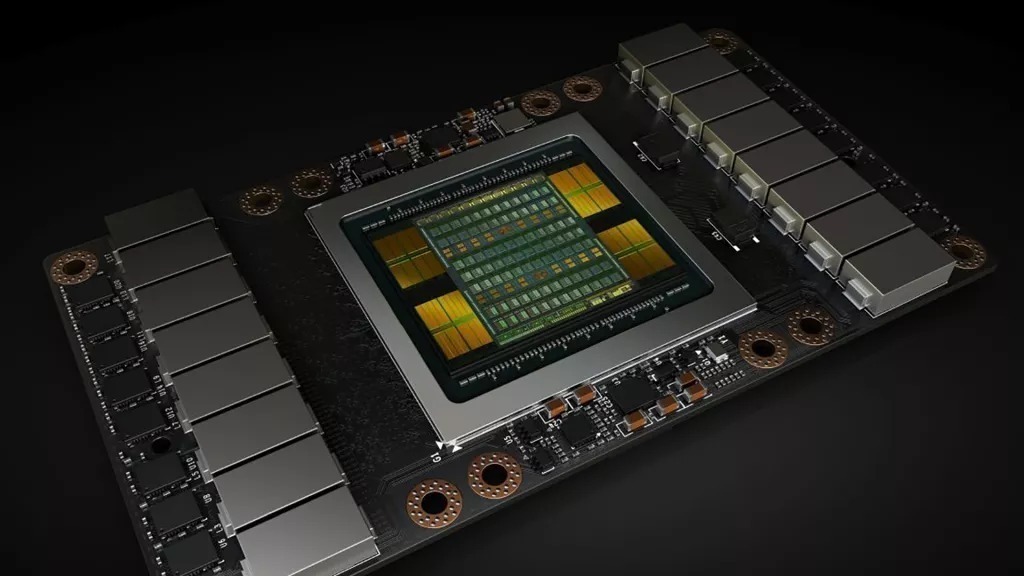

Nvidia, IBM e pesquisadores estão desenvolvendo uma tecnologia que pode revolucionar o universo da computação e de machine learning. O projeto consiste em conectar GPUs diretamente a SSDs, o que deve acelerar consideravelmente a transferência de dados entre os componentes.

Patenteada pela Nvidia, a tecnologia já tem nome: Big Accelerator Memory (BaM). De maneira geral, pode-se resumir o BaM a uma maneira de a GPU ter acesso a uma grande quantidade de armazenamento utilizável — no caso, os SSDs —, independentemente da CPU.

A descoberta será extremamente útil para cargas de trabalho intensivas como computacional, inteligência artificial (IA) ou de machine learning, processos que exigem grandes quantidades de dados e, ao mesmo tempo, grandes quantidades de memória dedicada.

“O BaM mitiga a amplificação do tráfego de E/S, permitindo que threads da GPU leiam ou gravem pequenas quantidades de dados sob demanda, conforme determinado pela computação”, disseram os pesquisadores.

Funcionamento dessa conexão entre GPUs e SSDs

Os detalhes técnicos descritos no artigo de pesquisa são bastante complexos. Mas em suma, o BaM usa um cache de memória de GPU gerenciado por software junto de uma biblioteca em que os threads de GPU podem solicitar dados armazenados diretamente em SSDs NVMe. Todo esse fluxo de informações é gerenciado pelas GPUs.

“O objetivo do BaM é estender a capacidade de memória da GPU e aprimorar a largura de banda de acesso ao armazenamento eficaz, ao mesmo tempo em que fornece abstrações de alto nível para os threads da GPU para facilitar o acesso sob demanda e granular a estruturas de dados massivas na hierarquia de memória estendida”, explicou o artigo.

Como resultado, as GPUs tornam-se muito mais independentes e passam a não necessitar tanto das CPUs de usos geral aceleradas por hardware. Os testes comprovaram as expectativas e mostraram que GPUs e SSDs funcionaram muito bem juntos, transferindo dados rapidamente.

Em breve, a equipe por trás do projeto pretende abrir os detalhes de hardware e software para que terceiros construam esses sistemas. Não há previsão para que isso aconteça, mas as comunidades computacionais e, principalmente de machine learning, já devem estar comemorando.

Via: TechRadar

Comentários