Apple adia lançamento de recursos contra abuso infantil

Após críticas envolvendo a privacidade dos usuários, Apple afirma que vai otimizar ferramentas nos próximos mesesBy - Igor Shimabukuro, 3 setembro 2021 às 15:12

Ao que parece, as três medidas anunciadas pela Apple no mês passado para combater o abuso infantil não foram tão bem recebidas pela comunidade e por especialistas. Tanto que, nesta sexta-feira (3), a big tech atualizou a publicação feita anteriormente e informou que vai adiar o lançamento dos recursos que chegarão para iPhones, iPads e Macs.

“Anunciamos anteriormente planos para recursos destinados a ajudar a proteger crianças de predadores que usam ferramentas de comunicação para recrutá-los e explorá-los e para ajudar a limitar a disseminação de material de abuso sexual infantil. Com base no feedback de clientes, grupos de defesa, pesquisadores e outros, decidimos reservar um tempo adicional nos próximos meses para coletar informações e fazer melhorias antes de lançarmos esses recursos de segurança infantil extremamente importantes” — Comunicado da Apple

Embora a iniciativa signifique um grande reforço para a segurança das crianças contra predadores sexuais, ela tem sido alvo de inúmeras críticas. Uma delas menciona que o mecanismo utilizado para a detecção automática de Material de Abuso Sexual Infantil (CSAM, na sigla em inglês) não é 100% à prova de falhas e pode levar a falsos positivos.

Além disso, os usuários temem que a funcionalidade desses mecanismos possa ser expandida para criar um recurso de vigilância silencioso e bastante perigoso. Regimes autoritários, por exemplo, poderiam recorrer à tecnologia para suprimir opositores ou buscar elementos específicos em fotos, mesmo que essas pessoas não tenham cometido crime algum.

Isso sem contar, é claro, no temor de que dados, conversas e fotos dos usuários sejam acessadas pela gigante. Apesar dos receios, a Apple reforça que todas as análises serão feitas por machine learning, de modo a reforçar a proteção das crianças sem que a empresa tenha acesso direto aos conteúdos ou desrespeite as políticas de privacidade.

Novos recursos da Apple

Anunciada no começo de agosto, a iniciativa da Apple para combater o abuso infantil e a disseminação de CSAM baseia-se em três recursos específicos.

- Segurança na comunicação do app Mensagens

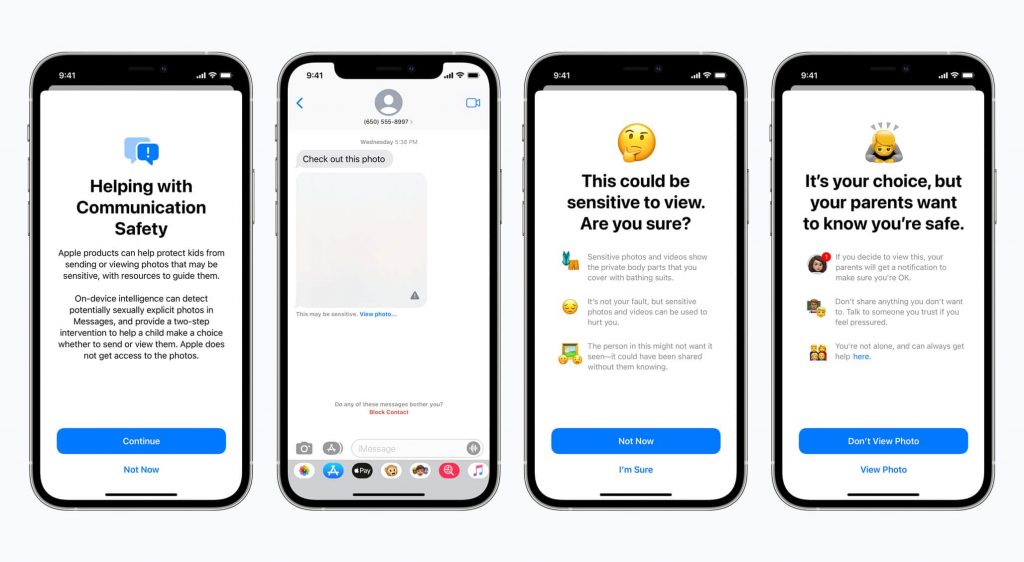

O primeiro recurso será voltado para o aplicativo Mensagens: a Apple vai adicionar novas ferramentas capazes de alertar, tanto as crianças quanto seus responsáveis, em caso de envio ou recebimento de fotos sexualmente explícitas.

Ao receber este tipo de conteúdo, a foto será desfocada, impedindo que a imagem possa ser pré-visualizada (similar ao recurso presente no Facebook). Uma primeira mensagem de conteúdo sensível será enviada. Caso o usuário avance para visualizar a mídia, um segundo alerta será emitido pela Apple, informando que os responsáveis serão notificados.

Segundo a empresa, recurso não vai interferir na privacidade do usuário. Divulgação: Apple

Já em casos de envio de imagens sexualmente explícitas pelas crianças, uma proteção semelhante atuará no app. Os jovens serão alertados antes da ação e os pais também vão receber uma mensagem.

- Detecção de CSAM

Outro recurso anunciado foi uma ferramenta de monitoramento para mitigar a disseminação de CSAM. A aplicação chegou a circular na internet anteriormente, mas ainda como rumor. Pouco depois, a Apple acabou confirmando o mecanismo.

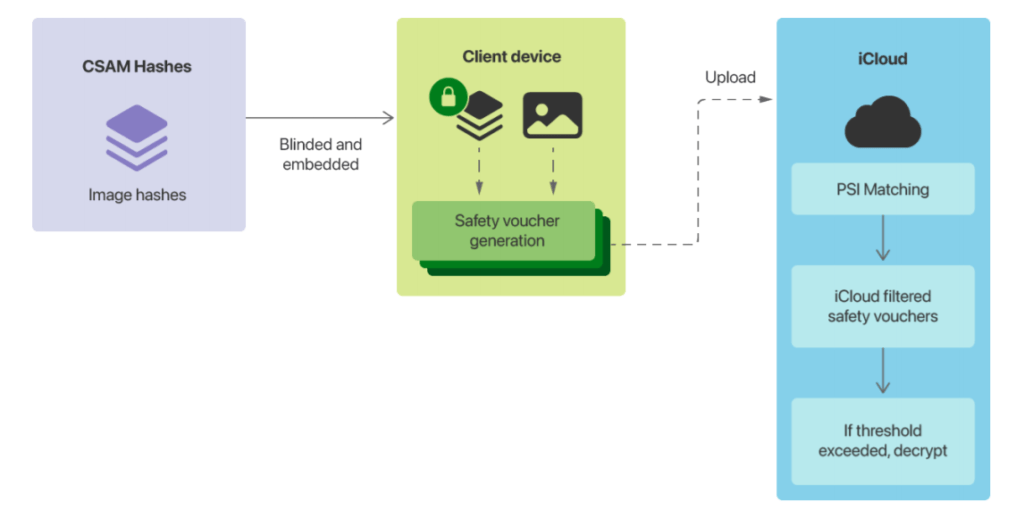

Basicamente, a tecnologia vai detectar imagens CSAM armazenadas no app Fotos, do iCloud. Ao invés de digitalizar imagens na nuvem, o sistema executa a correspondência no dispositivo usando um banco de dados de hashes (sequência de bits gerada por um algoritmo) de imagem CSAM fornecidos por organizações de segurança infantil.

Funcionamento da nova ferramenta de escaneabilidade das fotos do iCloud. Divulgação: Apple

Todo esse rastreamento será feito por meio de tecnologia. No entanto, se a conta ultrapassar um limite de conteúdos CSAM, os materiais serão interpretados manualmente pela Apple, que poderá tomar medidas diretas com autoridades policiais responsáveis.

- Siri e Pesquisa

A última novidade será uma espécie de suporte para crianças e os pais: a assistente de voz da big tech e o recurso de busca vão auxiliar usuários que queiram saber como ou onde registrar uma denúncia envolvendo CSAM ou exploração infantil, por exemplo.

Big tech vai reforçar o suporte para casos relacionados à CSAM. Divulgação: Apple

Caso o usuário realize buscas envolvendo CSAM, as ferramentas vão alertar que “o interesse neste tópico é prejudicial e problemático”, além de fornecer recursos de parceiros para obtenção de ajuda.

Mudanças à caminho

Vale lembrar que a atualização do comunicado não chegou a revelar quais mudanças serão feitas ou mesmo quando os recursos serão anunciados.

O informe cita uma análise que pode durar meses, mas é bem possível que todos os recursos cheguem ainda este ano por meio de atualizações para o iOS 15, iPadOS 15, watchOS 8 e macOS Monterey.

Fonte: Apple

Comentários