Karen e Carol: como o algoritmo Facebook lucra com polarização política

Um história sobre algoritmo está entre os documentos revelados por ex-funcionária do FacebookBy - Renata Aquino, 26 outubro 2021 às 9:40

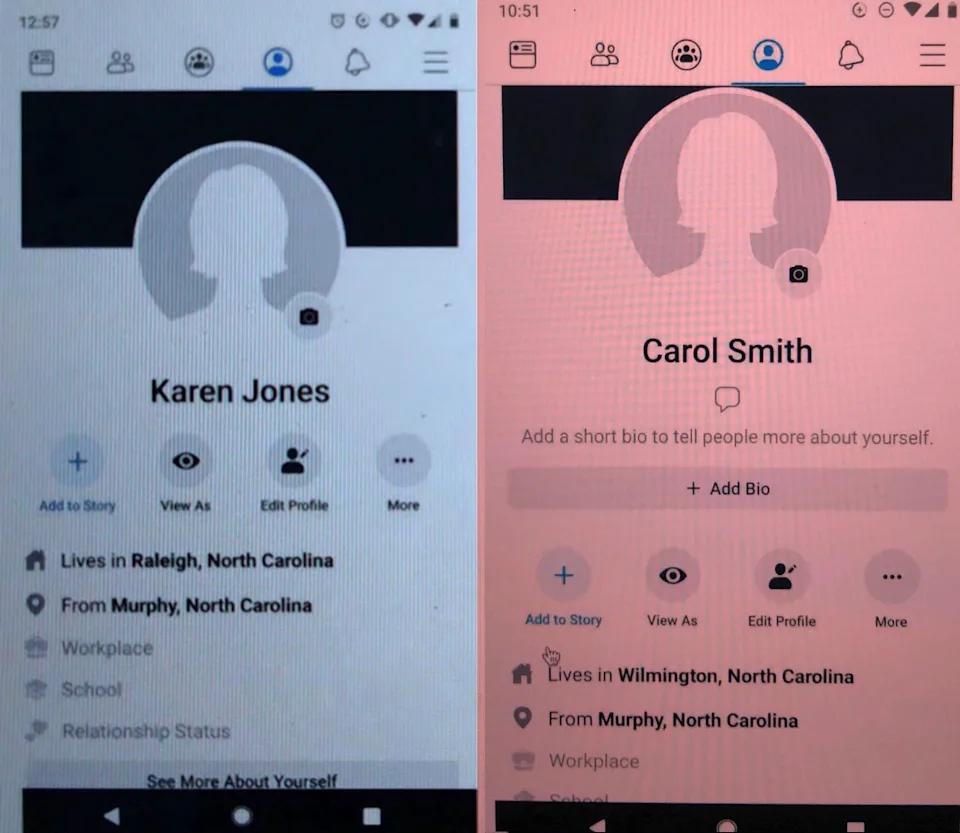

Entre os documentos revelados pela denunciante Frances Haugen, ex-funcionária do Facebook, a uma investigação no congresso americano, está uma história sobre o funcionamento do algoritmo da rede social. Dois perfis, Karen Jones e Carol Smith, foram criados para examinar como a plataforma pode lucrar com a promoção de embates políticos.

Em 2019, duas usuárias entraram no Facebook. Ambas com interesses similares: crianças pequenas, maternidade, cristianismo, comunidade e política. A história foi contada em detalhes pelo USA Today.

Carol, 41, era uma fã do partido conservador e de Donald Trump. Karen tinha a mesma idade, mas era liberal e não gostava de Trump. O algoritmo do Facebook mostrava a cada perfil o que poderia interessá-las. Rapidamente, sugeriu às duas usuárias seguir contas extremistas no espectro político.

Como a rede social aumenta conflitos políticos

Os dois perfis eram experimentos do próprio Facebook. Um pesquisador da empresa explorava como a rede social poderia aumentar a polarização política. A ideia era ver como cidadãos comuns podiam ser colocados em lados cada vez mais opostos, sugerindo conteúdo de desinformação e extremismo.

O experimento mostrou que a rede social de Mark Zuckerberg, hoje com quase 3 milhões de usuários ativos, sabia antes das eleições que suas recomendações ampliaram a desinformação e a polarização no país. Mais preocupante ainda, a empresa falhou em inibir conflitos resultantes disto.

O algoritmo foi mudado pelo Facebook novamente ano passado logo antes das eleições americanas para diminuir conflitos em posts de política e saúde. No entanto, Zuckerberg foi relutante à ideia de expandir as mudanças para outros tipos de publicações. A preocupação era que isso diminuísse o engajamento de usuários, de acordo com memorando interno. “Mark não acha que deveríamos ampliar isso”, era a informação registrada.

Facebook precisa fazer mudanças

O pesquisador que criou as personagens Karen e Carol sugeriu ainda mais mudanças. As sugestões de conteúdo deveriam excluir grupos ou páginas com referências a teorias conspiratórias em seus nomes. Grupos com administradores que já haviam infringido regras do Facebook também não deveriam ser sugeridos.

A denunciante, a motivação e a recompensa

Um porta-voz declarou que a empresa adotou algumas das recomendações do pesquisador no início de 2021. Um exemplo foi a eliminação do botão “curtir” quando qualquer conteúdo que viola as regras da empresa é identificado na plataforma.

Frances Haugen afirma ter tentado fazer com que o Facebook limitasse sua prática de priorizar conteúdo que atraía muitos compartilhamentos e comentários. Ela procurou proteção do governo americano alegando que o Facebook, uma empresa listada na bolsa, havia mentido para seus investidores.

Comentários